Los mejores contenidos sobre posicionamiento web se encuentran en ingles, para nadie es un secreto que estos SEOs profesionales son unos verdaderos maestros. Es por ello que en esta oportunidad queremos compartir con ustedes un caso real, donde un sitio web aumento su tráfico web en un 187% en tan solo 10 días.

El artículo se encuentra en ingles, por lo cual hemos realizado la traducción del mismo pero no de manera integra sino con sentido y haciendo algunos apuntes para entender como el actuar pronto y con decisión puede ser una gran jugada en el mundo del posicionamiento.

Penguin 3.0 recuperación de último minuto

Bueno, en concreto la historia es sobre una agencia de Marketing Italiana que trabaja con una empresa de SEO conocida como Elephate y es liderada por Bartosz Góralewicz y ?ukasz Kalus, quienes están certificados por la compañía Linkresearchtools.com (lideres en el desarrollo de programas para SEO).

Resulta que un día para ser concretos el 4 de Octubre de 2014 su cliente (la agencia de marketing) estaba leyendo una noticia en el blog Searchengineland.com donde la misma daba a conocer que el Penguin 3.0 seria lanzado dentro de una semana.

Preocupados por tal noticia, la agencia llamo a Bartosz Góralewicz comentándole la noticia y diciéndole que estaban preocupados por la actualización del Pingüino y como este afectaría el posicionamiento de ellos.

Los SEOs eran conscientes de que esta actualización si perjudicaría el sitio debido a que tenía demasiados enlaces entrantes que iban a perjudicarlos. Como contramedida decidieron emplear un plan al cual denominaron “Intervención Penguin 3.0”

1 Paso – Auditar los enlaces entrantes

La primera labor y más importante antes de realizar el proceso para llevar acabo su plan, era auditar los enlaces entrantes. Es decir, conocer el estado de los Backlinks que poseía el dominio web del cliente para ello sabía que tenían que aplicar la siguiente forma de trabajo 20% de estrategia, 20% de conocimiento y un 60% de dedicación y paciencia.

Objetivos

En esta primera etapa los objetivos eran auditar los enlaces que se encontrarán en alguna de estas categorías:

- Directorios de SEO

- Contenidos duplicados y Spam

- Spam en Foros

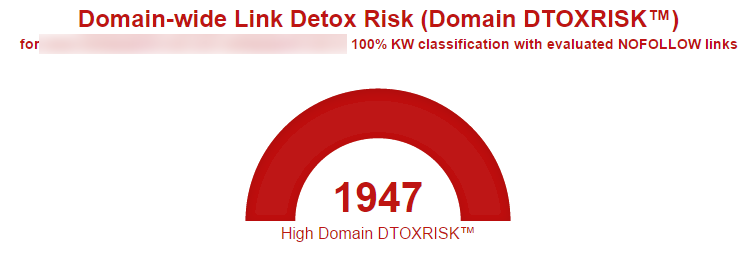

Tras ello obtuvieron la siguiente información, mostrando el numero de enlace tóxicos que tenia el dominio:

Línea de trabajo para auditar los Links

Hasta este punto ya tenían claro cuantos enlaces entrantes iban a auditar, ahora tocaba mantener una línea de trabajo sobre las herramientas que se utilizarían para auditar dichos enlaces y saber si son buenos o no para el cliente.

Su línea de trabajo estuvo basada en los siguientes tres pasos:

- Encontrar todos los Backlinks posibles utilizando Google Webmaster Tools, LinkResearchTools, Ahrefs, SEO Spy Glass and scrapers (es la utilización de footprint en Google para encontrar links).

- Analizar que tan toxico era el nicho y los links de la competencia.

- Diagnosticar todos los Links para posteriomente hacer la revision de forma manual.

Porcentajes de enlaces entrantes

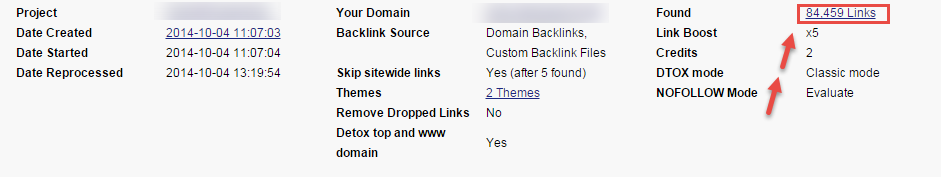

Antes de seguir, resulta imperante conocer algunos datos estadísticos del sitio web cliente:

- Es una agencia de Marketing Italiana

- Tiene un total de 785 referencias de dominios

- 84.500 enlaces de referencia

- 4.000 paginas indexadas

- 3 años en el mercado

Tras hacer la tarea de auditor los Links en el primer paso, los profesionales del SEO optaron por dejar un total 260 links entrantes de un total de 136 dominios. Esto quiere decir que desautorizaron el 99,7% de los Backlinks.

Esta decisión fue tomada luego de haber conversado con sus clientes, quienes eran conscientes que su tráfico bajaría notablemente en el momento en que desautorizaran toda esa cantidad de Backlinks y su salvación solo seria la entrada de Penguin 3.0

Comienza la desautorización de enlaces

En esta paso y valga la aclaración todas las técnicas realizadas por ellos fueron White Hat, por lo cual muchas de estas es probable que ya las conozcas. Para desautorizar los Links utilizaron estos tres pasos:

Exportar los enlaces entrantes en un archivo TXT (Bloc de notas)

Verificar que las URLs no estuvieran duplicadas

Usar la herramienta de Google para reindexar las URLs entrantes que quedarían

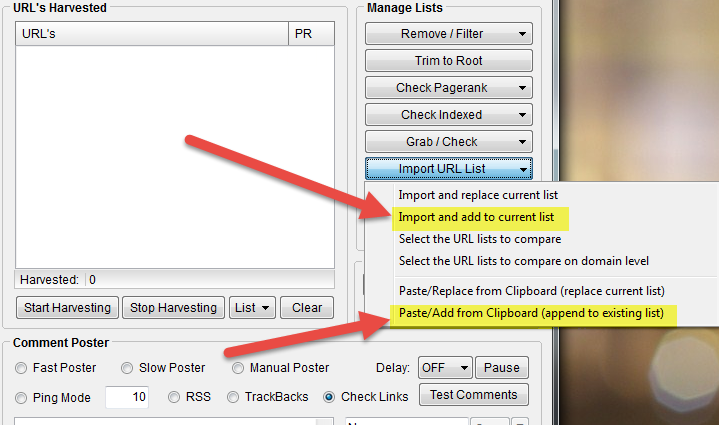

Eliminando las URLs duplicadas con ScrapeBox

Muchos de ustedes ya conocen esta herramienta así que no entraremos en muchos detalles. Para nuestra tarea haremos lo siguiente:

1. Abrimos el programa ScrapeBox

2. Hacemos clic en “Import URL list”

3. Copiamos y pegamos o lo hacemos desde “Import and add to current list” donde escogeremos el archivo TXT que exporamos anteriormente.

4. Repetimos la terea en caso de tener varias listas

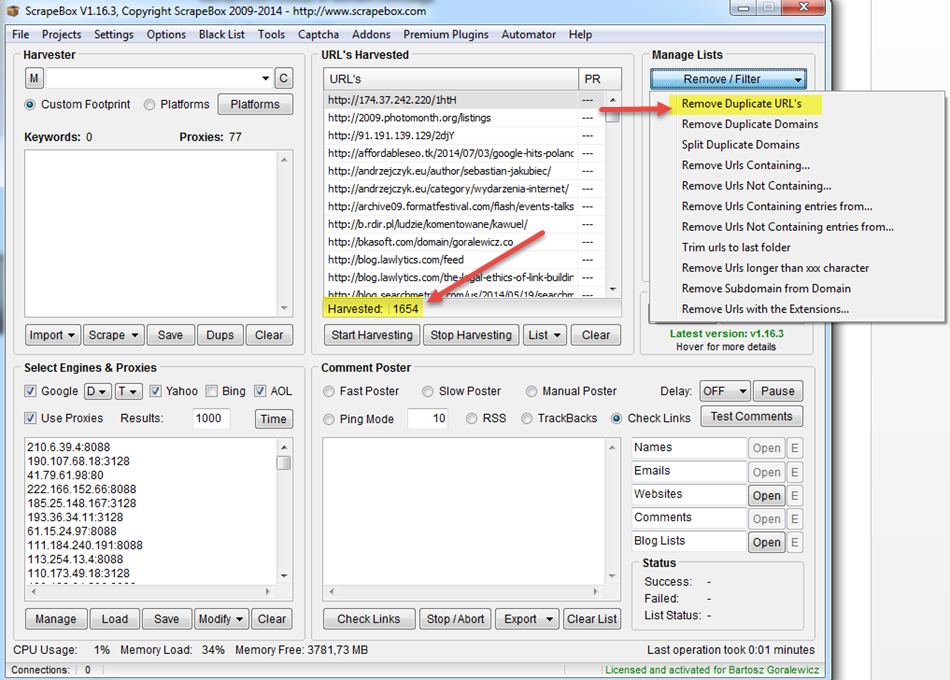

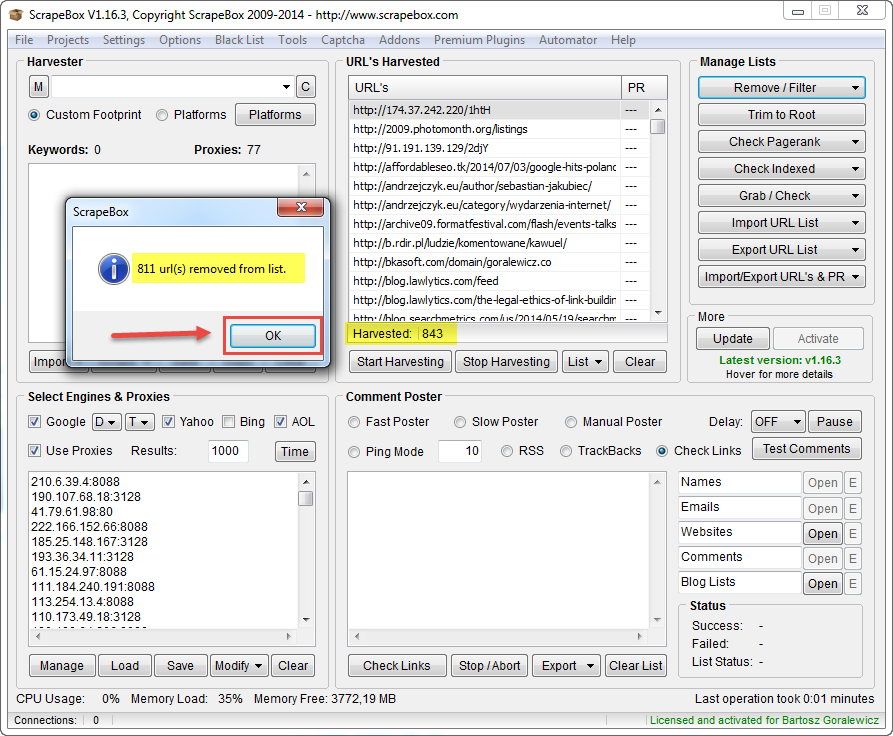

5. Despues pegamos todas las URLs y hacemos clic en Remove/Filter

6. Seleccionamos Remove Duplicate URLs

Listo ya abremos terminado y tendremos la lista de URLs que vamos a desautorizar totalmente limpias sin duplicaciones. Ya podemos proceder a la desautorización de los enlaces.

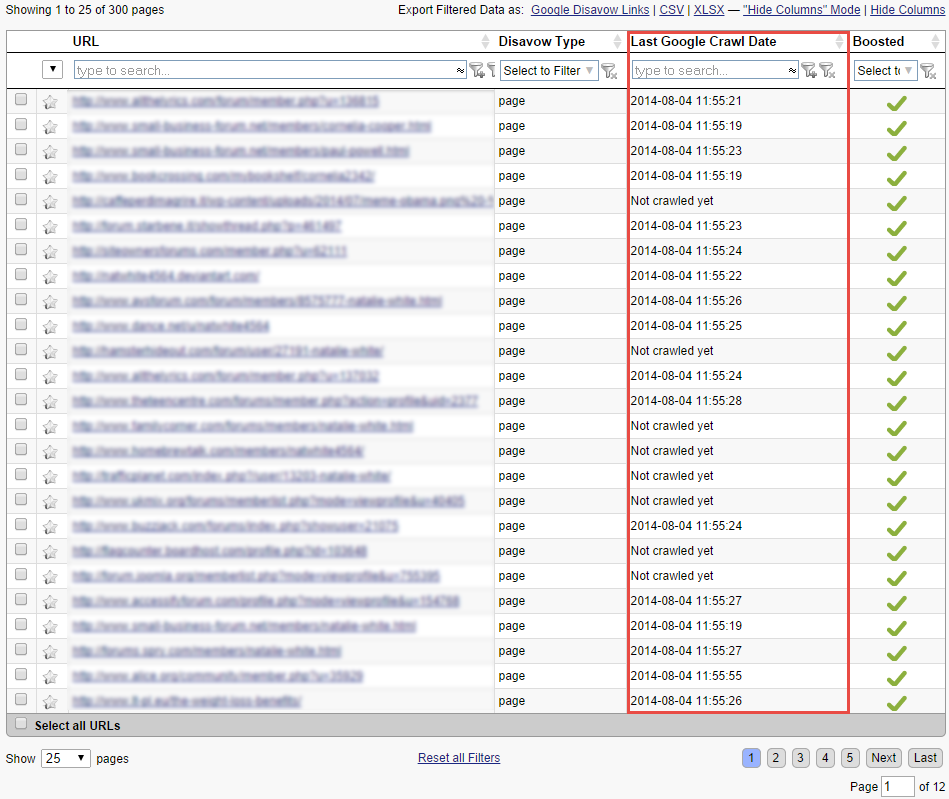

Posteriormente después de haber echo esto utilizaremos Link Detox Boost para comprobar y reafirmar los enlaces entrantes que deseamos sigan siendo rastreados por Google.

Resultados del trabajo de SEO

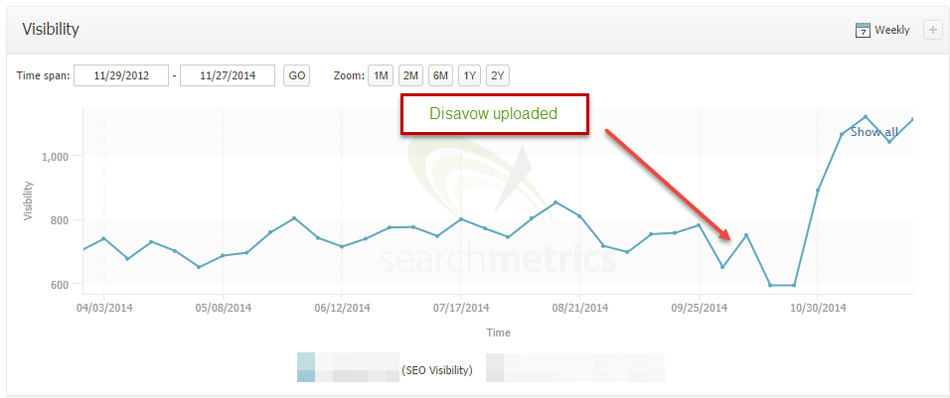

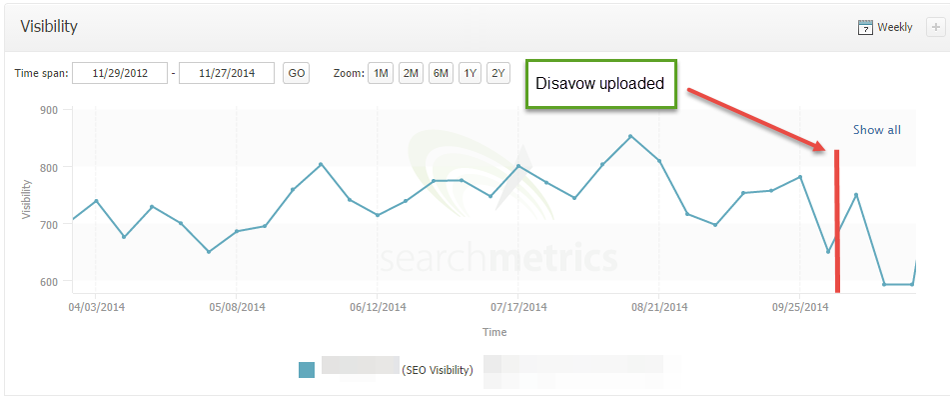

Arriba aparece el screen del trafico y como bajo el mismo en el momento en que se solicito la desautorización de Links, la cual se realizo con tres días de retraso frente a la llegada de Penguin 3.0

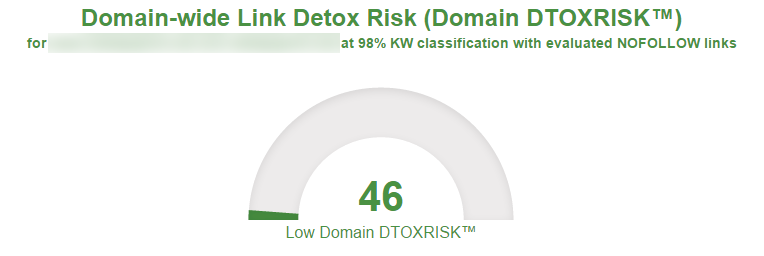

Y acá en esta otra imagen aparece el increíble y asombroso crecimiento que tuvo el trafico del sitio web después de la llegada del algoritmo, siendo bendecidos por el algoritmo del buscador y obteniendo no solo la posición que ocupaban en las SERPs sino un aumento en el trafico web del 187%.

Fuente – trabajos de estudio con http://www.linkresearchtools.com/

2 Comments